Inhoudsopgave

Voor mensen die websites bezitten, in SEO werken of websites bouwen, zijn er veel webcrawlers waar je vanaf moet weten. Het is belangrijk om te begrijpen hoe ze werken, je site gemakkelijk leesbaar te maken en je gegevens veilig te houden.

Deze gids leert je meer over de 15 meest gebruikte webcrawlers op 2026. Je leert wat ze doen, hoe ze verschillen en waarom ze belangrijk zijn voor je website. Of je nu nieuw bent met websites of een SEO expert, deze gids zal je helpen met webcrawlers te werken en je site te verbeteren.

Wat zijn webcrawlers en hoe werken ze?

Webcrawlers zijn computerprogramma’s die websites op het internet doorzoeken. Ze werken zelfstandig, bezoeken webpagina’s, verzamelen informatie en vinden nieuwe pagina’s via links. Zie ze als bibliothecarissen die boeken ordenen, maar dan voor websites.

Dit is hoe webcrawlers werken:

- Ze beginnen met een lijst webadressen.

- Ze kijken naar de code van elke webpagina.

- Ze vinden links op de pagina en voegen die toe aan hun lijst.

- Ze herhalen dit proces voor nieuwe pagina’s die ze vinden.

Wanneer crawlers pagina’s bezoeken, slaan ze belangrijke informatie op. Dit kan tekst, afbeeldingen en andere gegevens over de pagina zijn. Zoekmachines zoals Google gebruiken deze opgeslagen informatie om mensen te helpen vinden wat ze zoeken.

Hoe webcrawlers je website beïnvloeden

Webcrawlers spelen een grote rol in hoe mensen je website online vinden. Ze bepalen mede of je site wordt weergegeven in de zoekresultaten en hoe hoog hij scoort. Door te begrijpen hoe crawlers naar je site kijken, kun je veranderingen aanbrengen zodat meer mensen je vinden via zoekmachines.

Maar webcrawlers kunnen ook problemen veroorzaken. Sommige slechte crawlers kunnen privégegevens meenemen of je website vertragen door te veel tegelijk te vragen. Daarom is het belangrijk om op de hoogte te zijn van de verschillende soorten crawlers die je site bezoeken.

De 15 meest voorkomende webcrawlers in 2026

Laten we nu eens kijken naar de 15 webcrawlers die je waarschijnlijk zult tegenkomen op 2026. We leggen uit wat ze zijn, wat ze doen en hoe ze je website kunnen beïnvloeden. Van de crawler van Google tot de crawlers die worden gebruikt door social media sites, elke crawler heeft zijn eigen speciale taak. Als je weet hoe ze werken, kun je je website beter vindbaar en bruikbaarder maken.

Crawlers van zoekmachines

Zoekmachines helpen mensen online informatie te vinden. Hun crawlers zoeken naar nieuwe webpagina’s, slaan er informatie over op en rangschikken ze. Laten we eens kijken naar de belangrijkste zoekmachine crawlers:

1. Googlebot: De belangrijkste crawler

Googlebot is de belangrijkste crawler van Google. Hij vindt nieuwe en bijgewerkte webpagina’s om toe te voegen aan de zoekresultaten van Google. Er zijn verschillende soorten Googlebot:

- Desktop Googlebot: Bekijkt pagina’s zoals een computergebruiker ze zou zien.

- Smartphone Googlebot: Controleert hoe pagina’s eruit zien op mobiele apparaten.

- Googlebot-Afbeelding: Vindt en bewaart informatie over afbeeldingen.

- Googlebot-Video: Zoekt naar video’s op het web.

- Googlebot-Nieuws: Richt zich op nieuwswebsites en -artikelen.

Om je website goed te laten presteren in Google-zoekopdrachten:

- Zorg dat het goed werkt op mobiele apparaten

- Help het snel laden

- Schrijf nuttige inhoud die de vragen van mensen beantwoordt

2. Bingbot: Microsofts webcrawler

Bingbot is een bot voor Microsofts zoekmachine Bing. Net als Googlebot bekijkt het webpagina’s en slaat het informatie op voor gebruik in zoekresultaten. Bingbot heeft ook desktop- en mobiele versies.

Om je site te helpen het goed te doen op Bing:

- Volg Bing’s regels voor websites

- Zoek naar verschillen tussen wat Bing en Google verkiezen

3. Yandex Bot: Voor Russische websites

Yandex, een populaire zoekmachine in Rusland, heeft een robotcrawler genaamd Yandex Bot. Deze bot controleert websites die relevant en nuttig zijn voor Russische gebruikers. Als je wilt dat mensen in Rusland jouw website vinden, moet je de Yandex Bot leren kennen.

Yandex Bot geeft om:

- Hoe nuttig je website is voor Russische gebruikers

- De kwaliteit van je inhoud

- Hoe gemakkelijk je site te gebruiken is

4. Baidu Spider: Voor Chinese websites

BaiduDe zoekmachinegigant Baidu heerst in China. Zijn crawler, Baidu Spiderbekijkt Chinese websites. Als je wilt dat mensen in China je site vinden, moet je Baidu Spider kennen.

Om het goed te doen op Baidu:

- Maak je website snel

- Zorg dat het goed werkt op mobiele apparaten

- Volg de Chinese regels voor websites

5. DuckDuckGo Bot: de privacyvriendelijke crawler

DuckDuckGo is een zoekmachine die veel om privacy geeft. Haar crawler, de DuckDuckGo Bot, respecteert de wensen van website-eigenaren over waar hij wel en niet naar moet kijken.

Als privacy belangrijk is voor jou of je gebruikers:

- Stel je robots.txt bestand correct in

- Geef duidelijke instructies aan de crawler over wat hij wel en niet kan zien

6. Andere zoekmachine-crawlers

Hoewel Google, Bing, Yandex, Baidu en DuckDuckGo de grootste zijn, zijn er ook andere zoekmachines met hun eigen crawlers:

- Yahoo! Slurp: Yahoo’s crawler

- SeznamBot: Gebruikt door Seznam. cz, populair in Tsjechië

- NaverBot: Werkt voor Naver, de belangrijkste zoekmachine in Zuid-Korea

- Ecosia Bot: Gebruikt door Ecosia, een zoekmachine die bomen plant

Als je mensen in specifieke landen wilt bereiken, moet je misschien ook aan deze crawlers denken

Crawlers voor sociale media

Sociale media maken een groot deel uit van hoe we het internet gebruiken. Deze sites hebben hun eigen crawlers die zoeken naar gedeelde links, berichten, foto’s en meer. Deze crawlers helpen gebruikers om interessante inhoud te vinden op hun platforms. Laten we eens kijken naar een aantal veelgebruikte crawlers voor sociale media.

1. Facebook Externe Hit

Wanneer je een link deelt op Facebook, wordt de Facebook Externe Hit crawler het uit. Hij bekijkt de pagina die je hebt gedeeld en maakt een kleine preview. Deze preview helpt andere mensen om te beslissen of ze op je link willen klikken.

Om je website er goed uit te laten zien op Facebook:

- Open Graph tags gebruiken

- Kies goede foto’s

- Schrijf korte, interessante beschrijvingen

2. Twitterbot

Twitterbot werkt voor Twitter. Het onderzoekt tweets, gebruikersprofielen en andere inhoud op Twitter. Het helpt mensen tweets met links te vinden en informatie op Twitter te zoeken.

Om het goed te doen op Twitter:

- Gebruik hashtags die bij je onderwerp passen

- Praten met andere gebruikers

- Nuttige informatie delen

3. Pinterest bot

Pinterest bot werkt voor Pinterest, een site waar mensen afbeeldingen en ideeën delen. Deze crawler helpt gebruikers bij het vinden van pins, borden en andere inhoud die mensen delen op Pinterest.

Als je Pinterest gebruikt voor je bedrijf:

- Mooie spelden maken

- Schrijf duidelijke beschrijvingen

- Gebruik woorden waar mensen naar kunnen zoeken

- Wees actief op Pinterest en praat met andere gebruikers

4. LinkedInBot

LinkedInBot werkt voor LinkedIn, een site voor professioneel netwerken. Hij bekijkt gebruikersprofielen, bedrijfspagina’s, artikelen en andere inhoud op LinkedIn. Dit helpt mensen banen te vinden, connecties te maken en meer te weten te komen over hun branche.

Om het goed te doen op LinkedIn:

- Schrijf een goede samenvatting van jezelf of je bedrijf

- Vermeld je vaardigheden en ervaring

- Deel nuttige informatie over je werk of bedrijfstak

Andere veelgebruikte webcrawlers

Naast zoekmachines en sociale media doen andere webcrawlers ander werk. Sommige verzamelen informatie voor SEO-tools, terwijl andere kopieën van websites opslaan. Hier zijn een paar belangrijke:

1. Rogerbot

Rogerbot werkt voor Moz, een bedrijf dat SEO-tools maakt. Het bekijkt websites en verzamelt gegevens over:

- Links naar je site vanaf andere sites

- Hoe belangrijk je site lijkt

- Andere SEO dingen

Deze informatie helpt mensen die de tools van Moz gebruiken om te controleren hoe hun website het doet.

Als je de tools van Moz gebruikt:

- Zorg ervoor dat Rogerbot je site kan lezen

- Gebruik gestructureerde gegevens om duidelijke informatie over je site te geven

2. AhrefsBot

AhrefsBot werkt voor Ahrefs, een ander bedrijf dat SEO tools maakt. Het kijkt vooral naar links tussen websites. Dit helpt gebruikers van Ahrefs om te zien:

- Wie linkt er naar hun site

- Waar ze nieuwe links kunnen krijgen

- Welke links hebben hun concurrenten

Als je Ahrefs gebruikt:

- Zorg ervoor dat AhrefsBot je site kan lezen

- Gebruik duidelijke links tussen pagina’s op je site

3. SemrushBot

SemrushBot werkt voor Semrush, een bedrijf dat veel online marketingtools maakt. Deze bot bekijkt veel dingen over websites:

- Links van andere sites

- Hoe gemakkelijk het is om de website te vinden als je online naar iets zoekt

- Welke advertenties gebruikt de site

- En meer

Deze informatie helpt gebruikers van Semrush om meer te weten te komen over hun eigen sites en hun concurrenten.

Als je Semrush gebruikt:

- Zorg ervoor dat SemrushBot je site kan lezen

- Gebruik goede SEO-praktijken op je site

4. Majestueus-12

Majestic-12 werkt voor Majestic, een bedrijf dat zich richt op links tussen websites. Het kijkt goed naar deze links en vertelt gebruikers:

- Hoeveel links verwijzen naar hun site

- Hoe goed die links zijn

- Hoe gerelateerd die links zijn aan hun site

Als je meer wilt weten over links naar je site:

- Zorg dat je pagina’s goed naar elkaar linken

- Maak het Majestic-12 gemakkelijk om je site te lezen.

Webcrawlers op je site herkennen en begrijpen

Je website krijgt veel bezoekers. Sommigen zijn mensen op zoek naar informatie of producten. Anderen zijn webcrawlers en computerprogramma’s die je site bekijken en gegevens verzamelen. Het is goed om het verschil tussen deze bezoekers te weten. Laten we eens kijken hoe je webcrawlers kunt herkennen en waarom dat belangrijk is.

Hoe je webcrawlers op je site kunt vinden

Hier zijn enkele manieren om te zien of een webcrawler je site bezoekt:

- Controleer de logbestanden van je server: Je server houdt bij wie je site bezoekt. Dit geldt ook voor webcrawlers. Je kunt zoeken naar speciale namen in deze records. De crawler van Google heet bijvoorbeeld “Googlebot/2.1”.

- Kijk naar hoe ze zich gedragen: Webcrawlers gedragen zich anders dan mensen.

Ze:

- Snel veel pagina’s bezoeken

- Volg een vast pad door je site

- Kan pagina’s bekijken die mensen normaal niet zien

- Gebruik online hulpmiddelen: Bekijk websites die je kunnen helpen bij het identificeren van webcrawlers. Deze tools kijken wie je site bezoekt en geven je rapporten over crawleractiviteiten.

Logboeken en gedrag van webcrawlers bekijken

Als je eenmaal weet welke crawlers op bezoek komen, kun je meer te weten komen over wat ze doen. Dit betekent dat je goed naar je serverlogs moet kijken om te zien:

- Crawlpatronen: Welke paden nemen crawlers door je site? Zien ze al je belangrijke pagina’s?

- Crawlfrequentie: Hoe vaak bezoeken verschillende crawlers je site? Dit kan laten zien hoe belangrijk zoekmachines het vinden.

- Crawlfouten: Hebben crawlers problemen wanneer ze langskomen? Als je deze problemen verhelpt, kan je site beter verschijnen in de zoekresultaten.

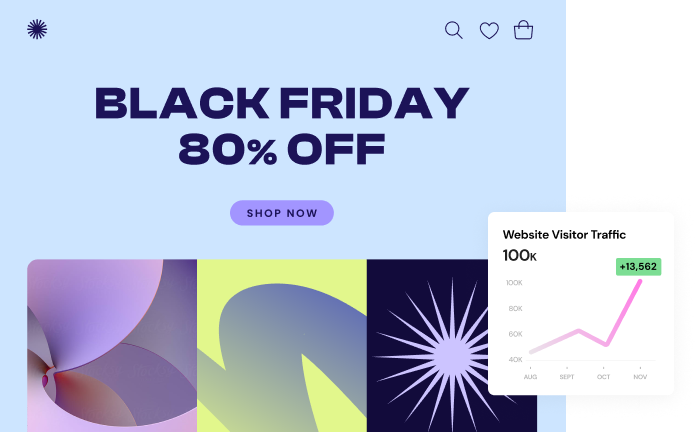

Als je Elementor gebruikt, kun je Google Analytics gebruiken om websiteverkeer bij te houden, inclusief crawlerbezoeken. Dit helpt je te begrijpen hoe crawlers zich gedragen op je site.

Hoe Elementor helpt bij websiteoptimalisatie

Met Elementor kun je weloverwogen beslissingen nemen om je website te verbeteren. Door te begrijpen hoe zoekmachines je site crawlen en hoe bezoekers met je site omgaan (met behulp van externe tools), kun je gebieden identificeren die voor verbetering vatbaar zijn. Als bepaalde pagina’s bijvoorbeeld niet vaak worden gecrawld, overweeg dan deze opties:

- Interne links tussen pagina’s aanpassen

- Een bijgewerkte sitemap indienen bij zoekmachines

Elementor vereenvoudigt het proces van het doorvoeren van wijzigingen en het evalueren van de impact ervan. Dat kan:

- De laadsnelheid van je site optimaliseren

- Zorg voor naadloze functionaliteit op mobiele apparaten

- Algehele gebruikerservaring verbeteren

Deze verbeteringen kunnen je site aantrekkelijker maken voor zowel zoekmachines als menselijke bezoekers.

Je website beter maken voor webcrawlers

Nu je meer weet over webcrawlers, laten we het hebben over hoe je je site beter voor hen kunt maken. Zie webcrawlers als gasten in je online huis. Je wilt het ze gemakkelijk maken om alle goede dingen op je site te zien. Dit gedeelte laat zien hoe je dat kunt doen.

Robots.txt gebruiken: Crawlers vertellen waar ze naartoe moeten.

Zie robots.txt als een teken voor webcrawlers. Het laat ze weten welke delen van je site verboden terrein zijn en welke ze vrij mogen verkennen. Het is een eenvoudig tekstbestand dat je op je website zet.

Waarom is robots.txt belangrijk? Het helpt je:

- Bepaal wat er wordt gecrawld: Je kunt zoekmachines naar de meest cruciale onderdelen van je website leiden als je wilt dat ze het belang ervan herkennen.

- Bescherm privégegevens: Je kunt voorkomen dat crawlers delen van je site zien die je privé wilt houden.

- Vermijd dubbele inhoud: Als je dezelfde inhoud op verschillende plaatsen hebt, kun je crawlers vertellen naar welke inhoud ze moeten kijken.

Hier is een eenvoudig voorbeeld van een robots.txt bestand:

User-agent: *

Disallow: /private/

Disallow: /temp/Dit vertelt alle crawlers (User-agent: *) om niet naar de /private/ en /temp/ mappen op je site te kijken.

Wees voorzichtig met robots.txt. Als je belangrijke pagina’s blokkeert, verschijnen ze misschien niet in de zoekresultaten. Je moet de juiste balans vinden.

XML-sitemaps maken en versturen: De Crawlers begeleiden

Een XML-sitemap kan worden vergeleken met een cartografische weergave van de structuur van een website, zodat crawlers gemakkelijk hun weg kunnen vinden. Het somt alle belangrijke pagina’s op je site op. Dit helpt crawlers om je inhoud snel en correct te vinden en te bekijken.

Hier is een eenvoudig voorbeeld van één pagina in een XML sitemap:

<url>

<loc>https://www.yourwebsite.com/blog/article-title</loc>

<lastmod>[year]-08-20</lastmod>

<changefreq>weekly</changefreq>

<priority>0.8</priority>

</url>Dit vertelt crawlers:

- Het webadres van de pagina (loc)

- Wanneer het voor het laatst is gewijzigd (lastmod)

- Hoe vaak het verandert (changefreq)

- Hoe belangrijk het is vergeleken met andere pagina’s (prioriteit)

Nadat je je sitemap hebt gemaakt, moet je deze aan zoekmachines doorgeven. Om dit gemakkelijker te maken, kun je tools gebruiken zoals Google Search Console of Bing Webmaster Tools.

Elementor Pro zelf genereert of update geen XML-sitemaps, maar het kan specifieke WordPress sitemap plugins aanvullen met een Sitemap Widget voor het handmatig maken van HTML-sitemaps binnen je Elementor pagina’s.

Website Structuur en Links Verbeteren: Crawling gemakkelijker maken

Zie je website als een goed georganiseerde stad. Hij moet duidelijke straten, aaneengesloten buurten en gemakkelijk te vinden oriëntatiepunten hebben, waardoor het voor webcrawlers gemakkelijk is om op je site rond te navigeren.

Hier zijn enkele manieren om je site beter te maken voor crawlers:

- Overzichtelijke organisatie: Groepeer je inhoud in categorieën. Dit helpt crawlers te begrijpen hoe je pagina’s aan elkaar gerelateerd zijn.

- Eenvoudige navigatie: Maak het voor mensen en crawlers eenvoudig om door je site te navigeren. Gebruik duidelijke menu’s en knoppen.

- Slimme interne links: Verbind gerelateerde pagina’s met links. Gebruik woorden in je links die beschrijven wat er op de gelinkte pagina staat.

Als je een eenvoudige manier wilt om je website te bouwen en te verbeteren, dan kan Elementor je helpen. Je kunt er gemakkelijk mooie, overzichtelijke websites mee maken. Elementor zorgt er ook voor dat je site goed werkt, waardoor crawlers je inhoud efficiënt kunnen bekijken.

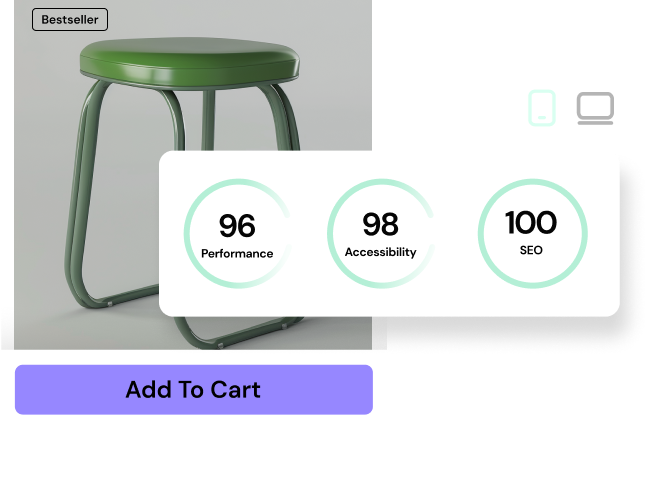

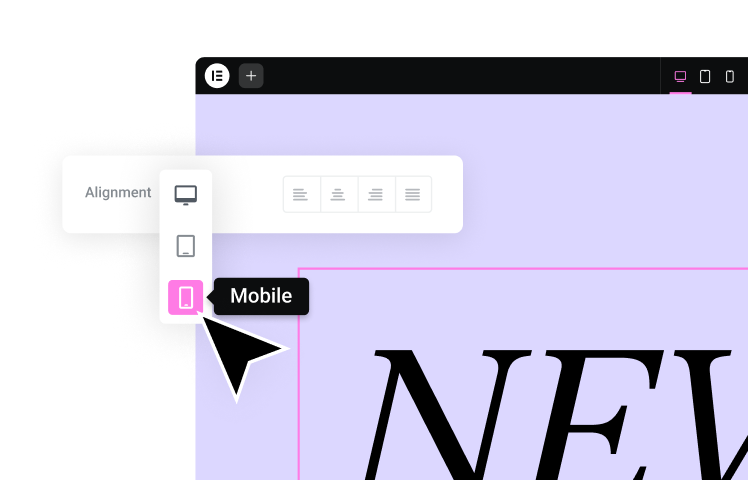

Elementor gebruiken om SEO-vriendelijke websites te maken

Elementor is meer dan alleen een hulpmiddel om websites te bouwen. Het helpt je om sites te maken die er goed uitzien en goed werken met zoekmachines. Hier lees je hoe Elementor je kan helpen:

- Schone code: Elementor maakt duidelijke, gemakkelijk leesbare code, waardoor zoekmachines de inhoud van je site beter begrijpen.

- Werkt op alle apparaten: Elementor helpt je sites te maken die er goed uitzien op computers, telefoons en tablets. Dit is belangrijk voor SEO.

- Snel laden: Elementor helpt je site snel te laden, wat goed is voor zowel bezoekers als zoekmachines.

Met deze functies kun je een website maken die er goed uitziet en goed werkt voor zowel mensen als zoekmachines.

Veelvoorkomende Crawler-problemen oplossen

Zelfs goed gemaakte websites kunnen soms problemen hebben met webcrawlers. Laten we eens kijken naar een aantal veelvoorkomende problemen en hoe je ze kunt oplossen.

Crawlbudget en -snelheid beheren

Het crawlbudget is als een boodschappenlijstje voor zoekmachines. Het bepaalt hoeveel pagina’s ze zullen bekijken op je website. De crawlsnelheid is hoe snel ze dit doen. Hier lees je hoe je het meeste uit je crawlbudget kunt halen:

- Maak belangrijke pagina’s gemakkelijk vindbaar

- Pagina’s van lage kwaliteit verwijderen of verbeteren

- Link je pagina’s goed aan elkaar

- Maak je site snel

Crawlfouten en 404-pagina’s oplossen

Crawlfouten treden op wanneer zoekmachines delen van je site niet kunnen bereiken. Veel voorkomende fouten zijn:

- Serverfouten (5xx): Je webserver werkt niet goed

- Fouten niet gevonden (404): Een pagina ontbreekt of is verplaatst

- Foutmelding Toegang geweigerd (403): De crawler is geblokkeerd voor sommige pagina’s

Om deze te repareren:

- Controleer je site regelmatig op fouten

- Gebroken links repareren

- Gebruik omleidingen als je pagina’s verplaatst

Hoewel Elementor zelf niet direct crawlfouten oplost, kan het wel helpen gebruikerservaring verbeteren door je in staat te stellen om aangepaste 404-pagina’s te maken. Deze pagina’s leiden bezoekers naar relevante inhoud, zelfs als ze een gebroken link of ontbrekende pagina tegenkomen.

Omgaan met dubbele inhoud

Dubbele inhoud betekent dat dezelfde tekst op meer dan één plaats op je site staat. Dit moet worden verduidelijkt voor zoekmachines. Om dit op te lossen:

- Gebruik speciale tags om zoekmachines te laten weten welke versie van een pagina het belangrijkst is.

- Zorg ervoor dat elke pagina op je site unieke inhoud heeft.

Elementor Pro kan een ingebouwde functie bieden om canonieke tags aan je pagina’s toe te voegen. Het is echter nog steeds cruciaal om originele en boeiende inhoud voor elke pagina te maken om problemen met dubbele inhoud te voorkomen en je bezoekers waarde te bieden.

Je website beschermen tegen slechte crawlers

Niet alle webcrawlers zijn goed. Sommige proberen gegevens te stelen of problemen te veroorzaken. Hier lees je hoe je je site kunt beschermen:

Slechte crawlers opsporen en blokkeren

Zoek naar crawlers die:

- Te snel te veel verzoeken doen

- Probeer toegang te krijgen tot delen van je site die je hebt geblokkeerd

- Gebruik verdachte namen

Om slechte crawlers te blokkeren:

- Blokkeer hun IP-adressen

- Blokkeer hun namen in je robots.txt bestand

- Gebruik een Web Application Firewall (WAF)

Zorg ervoor dat je goede crawlers niet per ongeluk blokkeert.

Je site veilig maken

Om je site veilig te houden:

- Gebruik sterke wachtwoorden en twee-factor authenticatie

- Houd je site en plugins up-to-date

- Gebruik een goed hostingbedrijf

- SSL gebruiken om gegevens te versleutelen

- Gebruik beveiligingsplugins

Hoe Elementor helpt met beveiliging

Elementor biedt functies om je site veilig te houden:

- Regelmatige beveiligingscontroles van haar code: Elementor controleert zijn codebase regelmatig om mogelijke kwetsbaarheden te identificeren en aan te pakken

- Verschillende toegangsniveaus voor gebruikers: Met het gebruikersrolsysteem van Elementor kun je bepalen wat verschillende gebruikers kunnen bewerken

- Compatibiliteit met beveiligingsplugins: Elementor werkt naadloos samen met populaire beveiligingsplugins om de bescherming van je site te verbeteren

Vergeet niet dat je ook andere best practices voor beveiliging moet gebruiken.

De toekomst van webcrawling

Het crawlen op het web verandert naarmate de technologie beter wordt. Dit is wat we in de toekomst zouden kunnen zien:

Slimmere Crawlers met AI

Toekomstige crawlers zouden kunstmatige intelligentie (AI) kunnen gebruiken om:

- Webpagina’s beter begrijpen

- Geef voorrang aan inhoud van hoge kwaliteit

- Gepersonaliseerde zoekresultaten geven

Ethisch crawlen

Naarmate crawlers slimmer worden, moeten ze zich aan de regels houden en de wensen van website-eigenaren respecteren. Dit omvat:

- Instructies voor robots.txt volgen

- Websites niet overbelasten

- Geen gevoelige gegevens meenemen

AI-functies van Elementor

Elementor gebruikt AI om het maken van websites gemakkelijker te maken. De AI-functies kunnen:

- Ideeën voor inhoud voorstellen

- Lay-outs genereren op basis van aanwijzingen

- Assisteren bij schrijftaken (genereren, vertalen, toon aanpassen)

Onthoud dat voor het optimaliseren van lay-outs voor gebruikerservaring en SEO extra tools en technieken binnen Elementor nodig zijn.

Wrap-Up

Webcrawlers zijn belangrijk om mensen te helpen online informatie te vinden. Door te begrijpen hoe ze werken, kun je je website gemakkelijker leesbaar maken. Hierdoor kunnen meer mensen je site vinden.

We hebben de 15 meest voorkomende webcrawlers op 2026 onderzocht, hoe je ze kunt herkennen en hoe je je site goed met ze kunt laten samenwerken. We hebben ook besproken hoe je je site kunt beschermen tegen slechte crawlers.

Onthoud dat een goede website goed werkt voor zowel mensen als webcrawlers. Deze handige gids kan je helpen om je website gastvrijer en toegankelijker te maken.

Wil je je website verbeteren?

Probeer Elementor om je website beter te maken. Het biedt:

- Een gebruiksvriendelijke websitebouwer

- AI-functies

- Veilige hosting

Bekijk Elementor vandaag nog om te zien hoe het jouw website kan helpen.

Op zoek naar verse inhoud?

Door je email in te voeren, ga je akkoord met het ontvangen van e-mails van Elementor, inclusief marketing e-mails,

en ga je akkoord met onze Algemene voorwaarden en Privacybeleid.