Inhaltsverzeichnis

Für Menschen, die Webseiten besitzen, in der SEO arbeiten oder Webseiten erstellen, gibt es viele Web-Crawler, die man kennen sollte. Es ist wichtig zu verstehen, wie sie funktionieren, Ihre Seite für sie lesbar zu machen und Ihre Daten sicher zu halten.

Dieser Leitfaden wird Ihnen die 15 häufigsten Web-Crawler in 2026 vorstellen. Sie werden lernen, was sie tun, wie sie sich unterscheiden und warum sie für Ihre Webseite wichtig sind. Egal, ob Sie neu in der Webseiten- oder SEO-Welt sind, dieser Leitfaden wird Ihnen helfen, mit Web-Crawlern zu arbeiten und Ihre Seite zu verbessern.

Was sind Web-Crawler und wie funktionieren sie?

Web-Crawler sind Computerprogramme, die Webseiten im Internet durchsuchen. Sie arbeiten unabhängig, besuchen Webseiten, sammeln Informationen und finden neue Seiten über Links. Denken Sie an sie wie an Bibliothekare, die Bücher organisieren, aber für Webseiten.

So funktionieren Web-Crawler:

- Sie beginnen mit einer Liste von Webadressen.

- Sie betrachten den Code jeder Webseite.

- Sie finden Links auf der Seite und fügen sie ihrer Liste hinzu.

- Sie wiederholen diesen Prozess für neue Seiten, die sie finden.

Während Crawler Seiten besuchen, speichern sie wichtige Informationen. Dies kann Text, Bilder und andere Daten über die Seite umfassen. Suchmaschinen wie Google verwenden diese gespeicherten Informationen, um Menschen zu helfen, das zu finden, wonach sie suchen, wenn sie suchen.

Wie Web-Crawler Ihre Webseite beeinflussen

Web-Crawler spielen eine große Rolle dabei, wie Menschen Ihre Webseite online finden. Sie helfen zu entscheiden, ob Ihre Seite in den Suchergebnissen erscheint und wie hoch sie rankt. Indem Sie verstehen, wie Crawler Ihre Seite betrachten, können Sie Änderungen vornehmen, um mehr Menschen über Suchmaschinen zu erreichen.

Aber Web-Crawler können auch Probleme verursachen. Einige schlechte Crawler könnten private Informationen stehlen oder Ihre Webseite verlangsamen, indem sie zu viele Anfragen auf einmal stellen. Deshalb ist es wichtig, über die verschiedenen Arten von Crawlern, die Ihre Seite besuchen, Bescheid zu wissen.

Die 15 häufigsten Web-Crawler in 2026

Schauen wir uns nun die 15 Web-Crawler an, die Sie am wahrscheinlichsten in 2026 sehen werden. Wir erklären, was sie sind, was sie tun und wie sie Ihre Webseite beeinflussen können. Von Googles Crawler bis hin zu denen, die von sozialen Medien-Seiten verwendet werden, hat jeder eine spezielle Aufgabe. Zu wissen, wie sie funktionieren, kann Ihnen helfen, Ihre Webseite leichter auffindbar und benutzbar zu machen.

Suchmaschinen-Crawler

Suchmaschinen helfen Menschen, online Informationen zu finden. Ihre Crawler suchen nach neuen Webseiten, speichern Informationen über sie und ranken sie. Schauen wir uns die wichtigsten Suchmaschinen-Crawler an:

1. Googlebot: Der wichtigste Crawler

Googlebot ist der Haupt-Crawler von Google. Er findet neue und aktualisierte Webseiten, um sie zu den Suchergebnissen von Google hinzuzufügen. Es gibt verschiedene Arten von Googlebot:

- Desktop Googlebot: Betrachtet Seiten, wie sie ein Computerbenutzer sehen würde.

- Smartphone Googlebot: Überprüft, wie Seiten auf mobilen Geräten aussehen.

- Googlebot-Image: Findet und speichert Informationen über Bilder.

- Googlebot-Video: Sucht nach Videos im Web.

- Googlebot-News: Konzentriert sich auf Nachrichtenwebseiten und Artikel.

Um Ihre Webseite in den Google-Suchergebnissen gut zu platzieren:

- Stellen Sie sicher, dass sie auf mobilen Geräten gut funktioniert

- Helfen Sie ihr, schnell zu laden

- Schreiben Sie hilfreiche Inhalte, die die Fragen der Menschen beantworten

2. Bingbot: Microsofts Web-Crawler

Bingbot ist ein Bot für die Bing-Suchmaschine von Microsoft. Wie Googlebot betrachtet er Webseiten und speichert Informationen für die Verwendung in den Suchergebnissen. Bingbot hat auch Desktop- und Mobilversionen.

Um Ihre Seite bei Bing gut zu platzieren:

- Befolgen Sie die Regeln von Bing für Webseiten

- Suchen Sie nach Unterschieden zwischen dem, was Bing und Google bevorzugen

3. Yandex Bot: Für russische Webseiten

Yandex, eine beliebte Suchmaschine in Russland, hat einen robotischen Crawler namens Yandex Bot. Dieser Bot überprüft Webseiten, die für russische Nutzer relevant und nützlich sind. Wenn Sie möchten, dass Menschen in Russland Ihre Webseite finden, sollten Sie sich über Yandex Bot informieren.

Yandex Bot achtet auf:

- Wie nützlich Ihre Webseite für russische Nutzer ist

- Die Qualität Ihrer Inhalte

- Wie benutzerfreundlich Ihre Seite ist

4. Baidu Spider: Für chinesische Webseiten

Baidu, der Suchmaschinenriese, herrscht in China vor. Sein Crawler, Baidu Spider, durchsucht chinesische Webseiten. Wenn Sie möchten, dass Menschen in China Ihre Seite finden, müssen Sie Baidu Spider kennen.

Um bei Baidu gut abzuschneiden:

- Machen Sie Ihre Webseite schnell

- Stellen Sie sicher, dass sie auf mobilen Geräten gut funktioniert

- Befolgen Sie die chinesischen Regeln für Webseiten

5. DuckDuckGo Bot: Der datenschutzfreundliche Crawler

DuckDuckGo ist eine Suchmaschine, die viel Wert auf Datenschutz legt. Ihr Crawler, DuckDuckGo Bot, respektiert die Wünsche der Webseitenbetreiber darüber, was er ansehen soll und was nicht.

Wenn Datenschutz für Sie oder Ihre Benutzer wichtig ist:

- Richten Sie Ihre robots.txt-Datei korrekt ein

- Geben Sie dem Crawler klare Anweisungen, was er sehen darf und was nicht

6. Andere Suchmaschinen-Crawler

Während Google, Bing, Yandex, Baidu und DuckDuckGo die größten sind, gibt es auch andere Suchmaschinen mit eigenen Crawlern:

- Yahoo! Slurp: Yahoos Crawler

- SeznamBot: Wird von Seznam.cz verwendet, beliebt in der Tschechischen Republik

- NaverBot: Arbeitet für Naver, die wichtigste Suchmaschine in Südkorea

- Ecosia Bot: Wird von Ecosia verwendet, einer Suchmaschine, die Bäume pflanzt

Wenn Sie Menschen in bestimmten Ländern erreichen möchten, sollten Sie auch über diese Crawler nachdenken

Social Media Crawler

Social Media ist ein großer Teil davon, wie wir das Internet nutzen. Diese Seiten haben ihre eigenen Crawler, die nach geteilten Links, Beiträgen, Bildern und mehr suchen. Diese Crawler helfen den Nutzern, interessante Inhalte auf ihren Plattformen zu finden. Schauen wir uns einige gängige Social Media Crawler an.

1. Facebook External Hit

Wenn Sie einen Link auf Facebook teilen, überprüft der Facebook External Hit-Crawler diesen. Er schaut sich die Seite an, die Sie geteilt haben, und erstellt eine kleine Vorschau. Diese Vorschau hilft anderen Menschen zu entscheiden, ob sie auf Ihren Link klicken sollen.

Damit Ihre Website auf Facebook gut aussieht:

- Verwenden Sie Open Graph-Tags

- Wählen Sie gute Bilder

- Schreiben Sie kurze, interessante Beschreibungen

2. Twitterbot

Twitterbot arbeitet für Twitter. Er untersucht Tweets, Benutzerprofile und andere Inhalte auf Twitter. Er hilft den Menschen, Tweets mit Links zu finden und nach Informationen auf Twitter zu suchen.

Um auf Twitter erfolgreich zu sein:

- Verwenden Sie Hashtags, die zu Ihrem Thema passen

- Sprechen Sie mit anderen Nutzern

- Teilen Sie hilfreiche Informationen

3. Pinterest bot

Pinterest bot arbeitet für Pinterest, eine Seite, auf der Menschen Bilder und Ideen teilen. Dieser Crawler hilft den Nutzern, Pins, Boards und andere Inhalte zu finden, die auf Pinterest geteilt werden.

Wenn Sie Pinterest für Ihr Geschäft nutzen:

- Erstellen Sie ansprechende Pins

- Schreiben Sie klare Beschreibungen

- Verwenden Sie Wörter, nach denen Menschen suchen könnten

- Seien Sie aktiv auf Pinterest und sprechen Sie mit anderen Nutzern

4. LinkedInBot

LinkedInBot arbeitet für LinkedIn, eine Seite für berufliches Networking. Er schaut sich Benutzerprofile, Unternehmensseiten, Artikel und andere Inhalte auf LinkedIn an. Dies hilft den Menschen, Jobs zu finden, berufliche Verbindungen zu knüpfen und mehr über ihre Branche zu erfahren.

Um auf LinkedIn erfolgreich zu sein:

- Schreiben Sie eine gute Zusammenfassung über sich oder Ihr Unternehmen

- Listen Sie Ihre Fähigkeiten und Erfahrungen auf

- Teilen Sie hilfreiche Informationen über Ihre Arbeit oder Branche

Andere gängige Webcrawler

Neben Suchmaschinen und sozialen Medien gibt es andere Webcrawler, die verschiedene Aufgaben erfüllen. Einige sammeln Informationen für SEO-Tools, während andere Kopien von Websites speichern. Hier sind einige wichtige:

1. Rogerbot

Rogerbot arbeitet für Moz, ein Unternehmen, das SEO-Tools herstellt. Er schaut sich Websites an und sammelt Daten über:

- Links zu Ihrer Seite von anderen Seiten

- Wie wichtig Ihre Seite erscheint

- Andere SEO-Dinge

Diese Informationen helfen den Nutzern von Moz-Tools zu überprüfen, wie ihre Website abschneidet.

Wenn Sie Moz-Tools verwenden:

- Stellen Sie sicher, dass Rogerbot Ihre Seite lesen kann

- Verwenden Sie strukturierte Daten, um klare Informationen über Ihre Seite zu geben

2. AhrefsBot

AhrefsBot arbeitet für Ahrefs, ein weiteres Unternehmen, das SEO-Tools herstellt. Er schaut sich hauptsächlich Links zwischen Websites an. Dies hilft Ahrefs-Nutzern zu sehen:

- Wer auf ihre Seite verlinkt

- Wo sie neue Links bekommen könnten

- Welche Links ihre Konkurrenten haben

Wenn Sie Ahrefs verwenden:

- Stellen Sie sicher, dass AhrefsBot Ihre Seite lesen kann

- Verwenden Sie klare Links zwischen den Seiten Ihrer Website

3. SemrushBot

SemrushBot arbeitet für Semrush, ein Unternehmen, das viele Online-Marketing-Tools herstellt. Dieser Bot schaut sich viele Dinge über Websites an:

- Links von anderen Seiten

- Wie leicht es ist, die Website zu finden, wenn man online nach etwas sucht

- Welche Anzeigen die Seite verwendet

- Und mehr

Diese Informationen helfen Semrush-Nutzern, mehr über ihre eigenen Seiten und ihre Konkurrenten zu erfahren.

Wenn Sie Semrush verwenden:

- Stellen Sie sicher, dass SemrushBot Ihre Seite lesen kann

- Verwenden Sie gute SEO-Praktiken auf Ihrer Seite

4. Majestic-12

Majestic-12 arbeitet für Majestic, ein Unternehmen, das sich auf Links zwischen Websites konzentriert. Er schaut sich diese Links genau an und teilt den Nutzern mit:

- Wie viele Links auf ihre Seite verweisen

- Wie gut diese Links sind

- Wie relevant diese Links für ihre Seite sind

Wenn Sie mehr über Links zu Ihrer Seite wissen möchten:

- Stellen Sie sicher, dass Ihre Seiten gut miteinander verlinkt sind

- Machen Sie es Majestic-12 leicht, Ihre Seite zu lesen.

Webcrawler auf Ihrer Website erkennen und verstehen

Ihre Website erhält viele Besucher. Einige sind Menschen, die nach Informationen oder Produkten suchen. Andere sind Webcrawler und Computerprogramme, die Ihre Seite durchsuchen und Daten sammeln. Es ist gut, den Unterschied zwischen diesen Besuchern zu kennen. Lassen Sie uns lernen, wie man Webcrawler erkennt und warum das wichtig ist.

Wie man Webcrawler auf seiner Website erkennt

Hier sind einige Möglichkeiten, um festzustellen, ob ein Webcrawler Ihre Website besucht:

- Überprüfen Sie Ihre Serverprotokolle: Ihr Server führt ein Protokoll über alle Besucher Ihrer Website. Dazu gehören auch Webcrawler. Sie können in diesen Aufzeichnungen nach speziellen Namen suchen. Zum Beispiel heißt der Crawler von Google „Googlebot/2.1“.

- Beobachten Sie ihr Verhalten: Webcrawler verhalten sich anders als Menschen.

Sie:

- Besuchen viele Seiten schnell

- Folgen einem festgelegten Pfad durch Ihre Website

- Könnten Seiten ansehen, die Menschen normalerweise nicht sehen

- Verwenden Sie Online-Tools: Schauen Sie sich Websites an, die Ihnen helfen können, Webcrawler zu identifizieren. Diese Tools analysieren, wer Ihre Website besucht, und geben Ihnen Berichte über die Aktivitäten der Crawler.

Betrachtung von Webcrawler-Protokollen und Verhalten

Sobald Sie wissen, welche Crawler Ihre Website besuchen, können Sie mehr darüber erfahren, was sie tun. Das bedeutet, dass Sie Ihre Serverprotokolle genau untersuchen, um zu sehen:

- Crawl-Muster: Welche Pfade nehmen die Crawler durch Ihre Website? Sehen sie alle wichtigen Seiten?

- Crawl-Häufigkeit: Wie oft besuchen verschiedene Crawler Ihre Website? Dies kann zeigen, wie wichtig Suchmaschinen Ihre Website einschätzen.

- Crawl-Fehler: Haben Crawler Probleme, wenn sie Ihre Website besuchen? Das Beheben dieser Probleme kann dazu beitragen, dass Ihre Website besser in den Suchergebnissen erscheint.

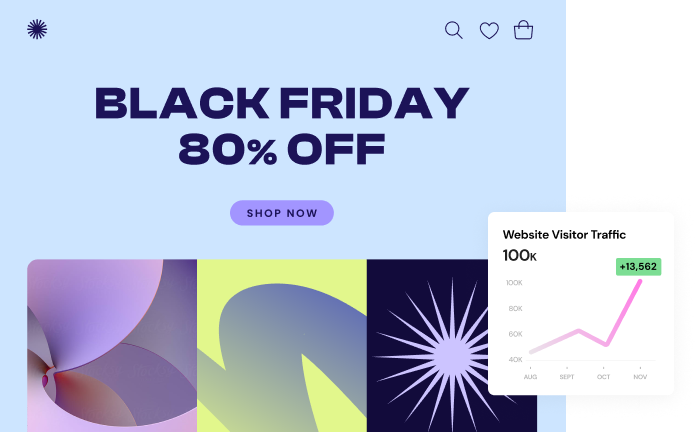

Wenn Sie Elementor verwenden, können Sie Google Analytics nutzen, um den Website-Traffic, einschließlich der Besuche von Crawlern, zu verfolgen. Dies hilft Ihnen zu verstehen, wie sich Crawler auf Ihrer Website verhalten.

Wie Elementor bei der Website-Optimierung hilft

Elementor ermöglicht es Ihnen, fundierte Entscheidungen zur Verbesserung Ihrer Website zu treffen. Indem Sie verstehen, wie Suchmaschinen Ihre Website crawlen und wie Besucher mit ihr interagieren (mithilfe externer Tools), können Sie Verbesserungsbereiche identifizieren. Wenn bestimmte Seiten beispielsweise nicht häufig gecrawlt werden, sollten Sie folgende Optionen in Betracht ziehen:

- Passen Sie interne Links zwischen den Seiten an

- Reichen Sie eine aktualisierte Sitemap bei Suchmaschinen ein

Elementor vereinfacht den Prozess der Umsetzung von Änderungen und der Bewertung ihrer Auswirkungen. Sie können:

- Optimieren Sie die Ladegeschwindigkeit Ihrer Website

- Stellen Sie eine nahtlose Funktionalität auf mobilen Geräten sicher

- Verbessern Sie das allgemeine Benutzererlebnis

Diese Verbesserungen können Ihre Website sowohl für Suchmaschinen als auch für menschliche Besucher attraktiver machen.

Ihre Website für Webcrawler verbessern

Jetzt, da Sie über Webcrawler Bescheid wissen, sprechen wir darüber, wie Sie Ihre Website für sie verbessern können. Denken Sie an Webcrawler als Gäste in Ihrem Online-Zuhause. Sie möchten es ihnen leicht machen, all die guten Dinge auf Ihrer Website zu sehen. Dieser Abschnitt zeigt Ihnen, wie das geht.

Verwendung von robots.txt: Den Crawlern sagen, wohin sie gehen sollen.

Denken Sie an robots.txt als ein Schild für Webcrawler. Es lässt sie wissen, welche Teile Ihrer Website tabu sind und welche sie frei erkunden können. Es ist eine einfache Textdatei, die Sie auf Ihrer Website platzieren.

Warum ist robots.txt wichtig? Es hilft Ihnen:

- Kontrollieren, was gecrawlt wird: Sie können Suchmaschinen zu den wichtigsten Bereichen Ihrer Website führen, wenn Sie möchten, dass sie deren Bedeutung erkennen.

- Private Informationen schützen: Sie können verhindern, dass Crawler Teile Ihrer Website sehen, die Sie privat halten möchten.

- Doppelte Inhalte vermeiden: Wenn Sie denselben Inhalt an verschiedenen Stellen haben, können Sie den Crawlern sagen, welche sie ansehen sollen.

Hier ist ein einfaches Beispiel für eine robots.txt-Datei:

User-agent: *

Disallow: /private/

Disallow: /temp/Dies teilt allen Crawlern (User-agent: *) mit, dass sie die Ordner /private/ und /temp/ auf Ihrer Website nicht ansehen sollen.

Seien Sie vorsichtig mit robots.txt. Wenn Sie wichtige Seiten blockieren, werden sie möglicherweise nicht in den Suchergebnissen angezeigt. Sie müssen das richtige Gleichgewicht finden.

Erstellung und Übermittlung von XML-Sitemaps: Die Crawler führen

Eine XML-Sitemap kann mit einer kartografischen Darstellung der Struktur einer Website verglichen werden, damit Crawler sich leicht zurechtfinden können. Sie listet alle wichtigen Seiten Ihrer Website auf. Dies hilft Crawlern, Ihre Inhalte schnell und korrekt zu finden und zu betrachten.

Hier ist ein einfaches Beispiel für eine Seite in einer XML-Sitemap:

<url>

<loc>https://www.yourwebsite.com/blog/article-title</loc>

<lastmod>[year]-08-20</lastmod>

<changefreq>weekly</changefreq>

<priority>0.8</priority>

</url>Dies teilt den Crawlern mit:

- Die Webadresse der Seite (loc)

- Wann sie zuletzt geändert wurde (lastmod)

- Wie oft sie sich ändert (changefreq)

- Wie wichtig sie im Vergleich zu anderen Seiten ist (priority)

Nachdem Sie Ihre Sitemap erstellt haben, müssen Sie Suchmaschinen darüber informieren. Um dies zu erleichtern, können Sie Tools wie Google Search Console oder Bing Webmaster Tools verwenden.

Elementor Pro selbst generiert oder aktualisiert keine XML-Sitemaps, kann jedoch dedizierte WordPress-Sitemap-Plugins ergänzen, indem es ein Sitemap-Widget für die manuelle Erstellung von HTML-Sitemaps innerhalb Ihrer mit Elementor erstellten Seiten anbietet.

Verbesserung der Website-Struktur und Links: Das Crawlen erleichtern

Denken Sie an Ihre Website als eine gut organisierte Stadt. Sie sollte klare Straßen, verbundene Viertel und leicht zu findende Wahrzeichen haben, was es Webcrawlern erleichtert, sich auf Ihrer Website zurechtzufinden.

Hier sind einige Möglichkeiten, um Ihre Website für Crawler zu verbessern:

- Klare Organisation: Gruppieren Sie Ihre Inhalte in Kategorien. Dies hilft Crawlern zu verstehen, wie Ihre Seiten miteinander verbunden sind.

- Einfache Navigation: Machen Sie es Menschen und Crawlern einfach, sich auf Ihrer Website zu bewegen. Verwenden Sie klare Menüs und Schaltflächen.

- Intelligente interne Verlinkung: Verbinden Sie verwandte Seiten mit Links. Verwenden Sie in Ihren Links Wörter, die beschreiben, was auf der verlinkten Seite zu finden ist.

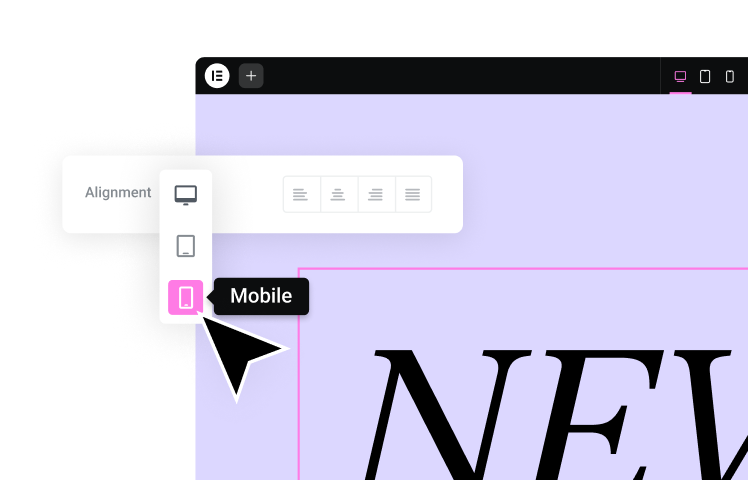

Wenn Sie eine einfache Möglichkeit suchen, Ihre Website zu erstellen und zu verbessern, kann Elementor Ihnen helfen. Es ermöglicht Ihnen, gut aussehende, gut organisierte Websites einfach zu erstellen. Elementor stellt auch sicher, dass Ihre Website gut funktioniert, was dazu beiträgt, dass Crawler Ihre Inhalte effizient anzeigen können.

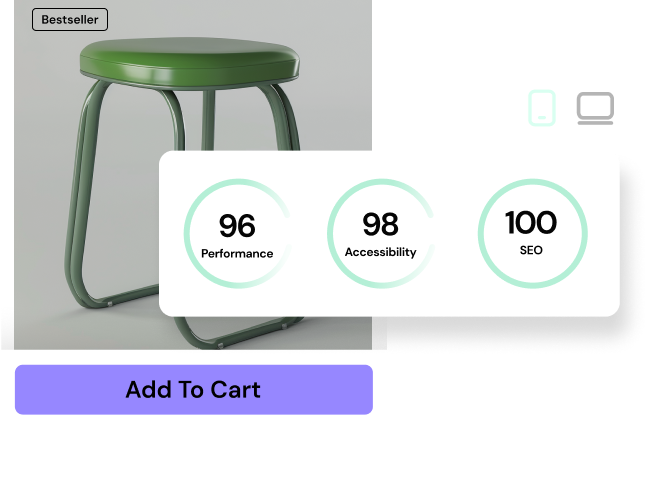

Mit Elementor SEO-freundliche Websites erstellen

Elementor ist mehr als nur ein Werkzeug zum Erstellen von Websites. Es hilft Ihnen, Websites zu erstellen, die gut aussehen und mit Suchmaschinen gut funktionieren. So kann Elementor helfen:

- Sauberer Code: Elementor erstellt klaren, leicht lesbaren Code, der Suchmaschinen hilft, den Inhalt Ihrer Website zu verstehen.

- Funktioniert auf allen Geräten: Elementor hilft Ihnen, Websites zu erstellen, die auf Computern, Telefonen und Tablets gut aussehen. Dies ist wichtig für SEO.

- Schnelles Laden: Elementor hilft Ihrer Website, schnell zu laden, was sowohl für Besucher als auch für Suchmaschinen gut ist.

Mit diesen Funktionen können Sie eine Website erstellen, die sowohl für Menschen als auch für Suchmaschinen gut aussieht und gut funktioniert.

Häufige Crawler-Probleme beheben

Selbst gut gemachte Websites können manchmal Probleme mit Web-Crawlern haben. Schauen wir uns einige häufige Probleme und deren Lösungen an.

Verwaltung des Crawl-Budgets und der Crawl-Rate

Das Crawl-Budget ist wie eine Einkaufsliste für Suchmaschinen. Es bestimmt, wie viele Seiten sie auf Ihrer Website überprüfen. Die Crawl-Rate ist, wie schnell dies geschieht. So nutzen Sie Ihr Crawl-Budget optimal:

- Machen Sie wichtige Seiten leicht auffindbar

- Entfernen oder verbessern Sie minderwertige Seiten

- Verlinken Sie Ihre Seiten gut miteinander

- Machen Sie Ihre Website schnell

Crawler-Fehler und 404-Seiten beheben

Crawler-Fehler treten auf, wenn Suchmaschinen auf Teile Ihrer Website nicht zugreifen können. Häufige Fehler sind:

- Serverfehler (5xx): Ihr Webserver funktioniert nicht richtig

- Nicht gefundene Fehler (404): Eine Seite fehlt oder wurde verschoben

- Zugriff verweigert Fehler (403): Der Crawler wird von einigen Seiten blockiert

Um diese zu beheben:

- Überprüfen Sie Ihre Website regelmäßig auf Fehler

- Reparieren Sie defekte Links

- Verwenden Sie Weiterleitungen, wenn Sie Seiten verschieben

Obwohl Elementor selbst keine Crawler-Fehler direkt behebt, kann es helfen, die Benutzererfahrung zu verbessern, indem es Ihnen ermöglicht, benutzerdefinierte 404-Seiten zu erstellen. Diese Seiten leiten Besucher zu relevanten Inhalten, selbst wenn sie auf einen defekten Link oder eine fehlende Seite stoßen.

Umgang mit doppeltem Inhalt

Doppelter Inhalt bedeutet, dass derselbe Text an mehr als einer Stelle auf Ihrer Website erscheint. Dies muss für Suchmaschinen klargestellt werden. So beheben Sie das:

- Verwenden Sie besondere Tags, um Suchmaschinen mitzuteilen, welche Version einer Seite die wichtigste ist.

- Stellen Sie sicher, dass jede Seite auf Ihrer Website einzigartige Inhalte hat.

Elementor Pro bietet eine integrierte Funktion, um kanonische Tags zu Ihren Seiten hinzuzufügen. Es ist jedoch weiterhin wichtig, originelle und ansprechende Inhalte für jede Seite zu erstellen, um Probleme mit doppeltem Inhalt zu vermeiden und Ihren Besuchern Mehrwert zu bieten.

Schutz Ihrer Website vor schlechten Crawlern

Nicht alle Web-Crawler sind gut. Einige versuchen, Daten zu stehlen oder Probleme zu verursachen. So schützen Sie Ihre Website:

Schlechte Crawler erkennen und blockieren

Achten Sie auf Crawler, die:

- Zu viele Anfragen zu schnell stellen

- Versuchen, auf Teile Ihrer Website zuzugreifen, die Sie blockiert haben

- Verdächtige Namen verwenden

Um schlechte Crawler zu blockieren:

- Blockieren Sie deren IP-Adressen

- Blockieren Sie deren Namen in Ihrer robots.txt-Datei

- Verwenden Sie eine Web Application Firewall (WAF)

Seien Sie vorsichtig, um nicht versehentlich gute Crawler zu blockieren.

Ihre Website sicher machen

Um Ihre Website sicher zu halten:

- Verwenden Sie starke Passwörter und Zwei-Faktor-Authentifizierung

- Halten Sie Ihre Website und Plugins auf dem neuesten Stand

- Verwenden Sie ein gutes Hosting-Unternehmen

- Verwenden Sie SSL, um Daten zu verschlüsseln

- Verwenden Sie Sicherheits-Plugins

Wie Elementor bei der Sicherheit hilft

Elementor bietet Funktionen, um Ihre Website sicher zu halten:

- Regelmäßige Sicherheitsüberprüfungen des Codes: Elementor überprüft regelmäßig seinen Code, um potenzielle Schwachstellen zu identifizieren und zu beheben

- Verschiedene Zugriffsebenen für Benutzer: Das Benutzerrollensystem von Elementor ermöglicht es Ihnen, zu steuern, was verschiedene Benutzer bearbeiten können

- Kompatibilität mit Sicherheits-Plugins: Elementor arbeitet nahtlos mit beliebten Sicherheits-Plugins zusammen, um den Schutz Ihrer Website zu verbessern

Denken Sie daran, auch andere bewährte Sicherheitspraktiken zu verwenden.

Die Zukunft des Web-Crawlings

Das Web-Crawling verändert sich, da die Technologie besser wird. Hier ist, was wir in Zukunft sehen könnten:

Intelligentere Crawler mit KI

Zukünftige Crawler könnten künstliche Intelligenz (KI) verwenden, um:

- Webseiten besser zu verstehen

- Hochwertige Inhalte zu priorisieren

- Personalisierte Suchergebnisse zu liefern

Ethisches Crawling

Da Crawler intelligenter werden, müssen sie die Regeln befolgen und die Wünsche der Website-Besitzer respektieren. Dies umfasst:

- Befolgen der robots.txt-Anweisungen

- Websites nicht überlasten

- Keine sensiblen Daten entnehmen

Elementors KI-Funktionen

Elementor verwendet KI, um die Erstellung von Websites zu erleichtern. Seine KI-Funktionen können:

- Inhaltsideen vorschlagen

- Layouts basierend auf Eingaben generieren

- Helfen Sie bei Schreibaufgaben (Erstellen, Übersetzen, Anpassen des Tons)

Denken Sie daran, dass die Optimierung von Layouts für Benutzererfahrung und SEO zusätzliche Werkzeuge und Techniken innerhalb von Elementor erfordert.

Zusammenfassung

Webcrawler sind wichtig, um Menschen dabei zu helfen, Informationen online zu finden. Indem Sie verstehen, wie sie funktionieren, können Sie Ihre Website für sie leichter lesbar machen. Dies kann dazu beitragen, dass mehr Menschen Ihre Seite finden.

Wir haben die 15 häufigsten Webcrawler untersucht, wie man sie in 2026 erkennt und wie man seine Seite gut mit ihnen arbeiten lässt. Wir haben auch besprochen, wie man seine Seite vor schlechten Crawlern schützt.

Denken Sie daran, eine gute Website funktioniert sowohl für Menschen als auch für Webcrawler gut. Dieser praktische Leitfaden kann Ihnen helfen, Ihre Website einladender und zugänglicher zu machen.

Möchten Sie Ihre Website verbessern?

Versuchen Sie Elementor, um Ihre Website zu verbessern. Es bietet:

- Einen benutzerfreundlichen Website-Builder

- KI-gestützte Funktionen

- Sicheres Hosting

Schauen Sie sich Elementor heute an, um zu sehen, wie es Ihrer Website helfen kann.

Suchen Sie nach neuen Inhalten?

Durch die Eingabe Ihrer email erklären Sie sich damit einverstanden, E-Mails von Elementor zu erhalten, einschließlich Marketing-E-Mails,

und stimmen unseren Allgemeinen Geschäftsbedingungen sowie unserer Datenschutzrichtlinie zu.